来源:阿尔法工场

最近,正在进行AI大战的各个大厂,被谷歌泄漏的一份内部文件,翻开了窘迫的一面。

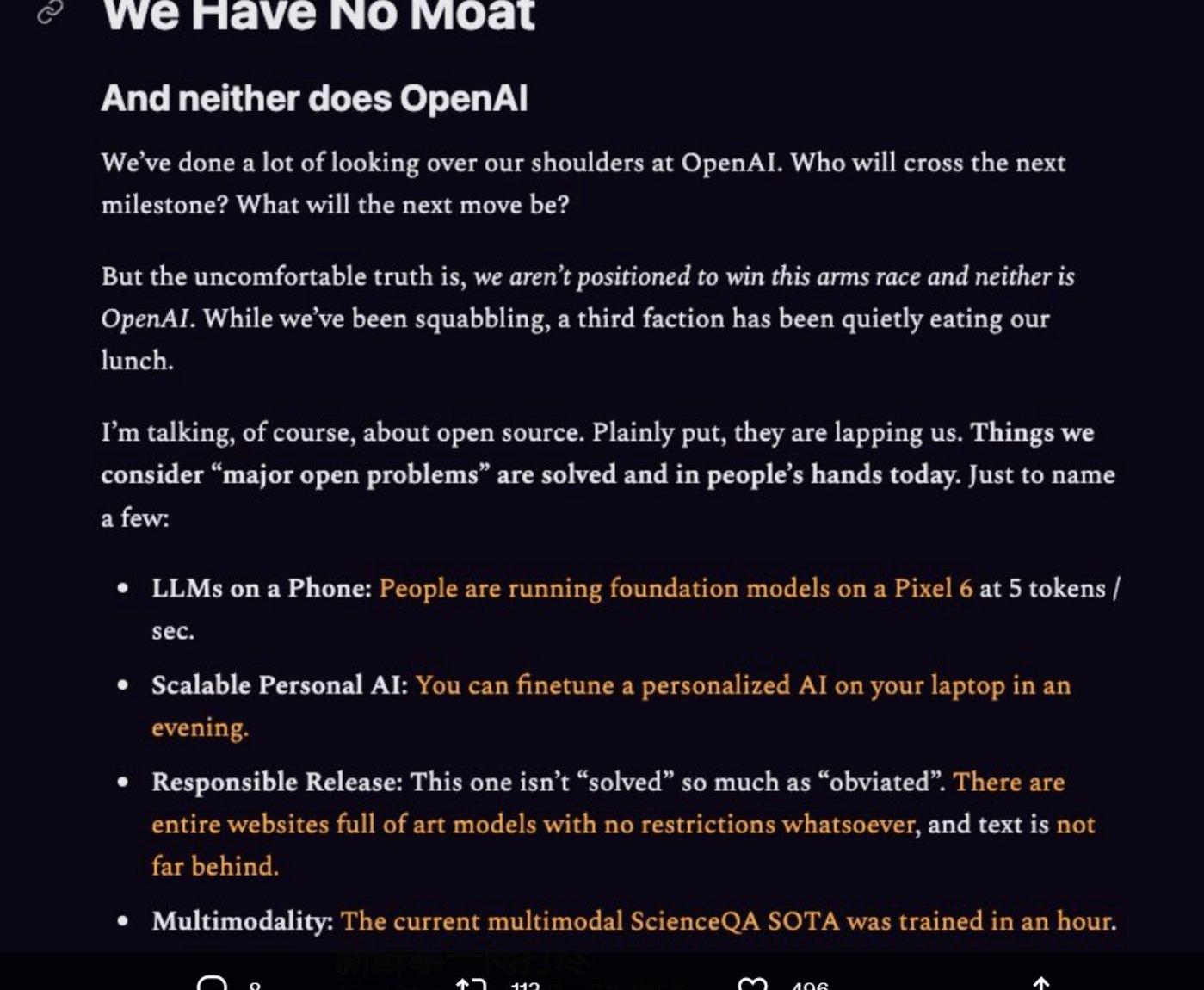

这份泄露的内部文件声称:“我们没有‘护城河’,OpenAI也没有。当我们还在争吵时,第三个方已经悄悄地抢了我们的饭碗——开源。”

这份文件认为,现在的一些开源模型,一直在照搬谷歌、微软这些大厂的劳动成果,并且双方差距正在以惊人的速度缩小。开源模型更快、可定制性更强、更私密,而且功能性也不落下风。

比如,这些开源模型可以用100美元外加13B参数,加上几个礼拜的时间就能出炉,而谷歌这样的大厂,要想训练大模型,则需要面对千万美元的成本和540B参数,以及长达数月的训练周期。

那么,事实是否真的像这份文件所说的那样,谷歌和OpenAI在AI方面的种种积累,最终真的会败给一群隐藏在民间的“草头侠”?

所谓“大厂垄断大模型”的时代,真的要终结了吗?

要回答这个问题,我们就得先了解下目前开源模型的生态,看看这些如雨后春笋般涌现的开源模型,究竟是如何一步步蚕食谷歌这些“正规军”的江山的。

推特“大V”Pentoshi透露已投资“一些”SHIB:金色财经报道,拥有46万粉丝的推特“大V”Pentoshi透露已投资了“一些”SHIB,但未公开购入数量,他表示通过分析SHIB的R/R(风险/回报率)认为自己可以从中获得预期回报。值得注意的是,Pentoshi 选择投资 SHIB 之际恰逢有传言称其会在今年二月登陆Robinhood,尽管此前Robinhood CFO已经暗示会保留上架SHIB的选择权。[2022/1/15 8:51:05]

01异军突起的开源模型

其实,最早的开源模型,其诞生完全是一场“偶然”。

今年2月,Meta发布了自家的大型语言模型LLaMA,参数量从70亿到650亿不等,并仅用130亿的参数,就在大多数基准测试下超越了GPT-3。

但万万没想到的是,刚发布没几天,LLaMA的模型文件就被泄露了。

至此之后,开源模型的浪潮就如决堤一般,变得一发不可收拾。

如八仙过海一般的ChatGPT开源替代品——「羊驼家族」,随即粉墨登场。

声音 | 美联储卡什卡利:加密货币是“大型垃圾装卸卡车”:美联储尼尔·卡什卡利(Neel Kashkari)将加密货币描述为“大型垃圾装卸卡车(垃圾桶)”。(金十)[2020/2/12]

与ChatGPT这类大模型相比,此类开源模型最显著的特点,就是训练成本与时间都极其低廉。

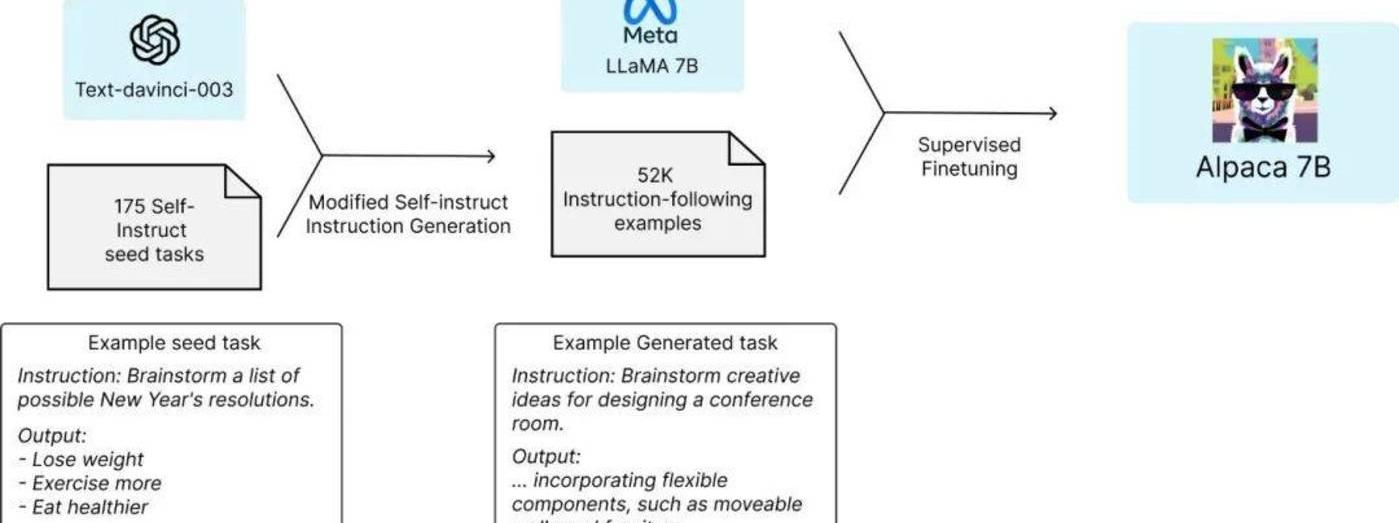

以LlaMA的衍生模型Alpaca为例,其训练成本仅用了52k数据和600美元。

然而,如果开源光靠低成本,还不足以让谷歌这类大厂感到威胁,重要的是,在极低的训练成本下,这些开源模型还能屡次达到和GPT-3.5匹敌的性能。

这下谷歌和OpenAI就坐不住了。

斯坦福研究者对GPT-3.5和Alpaca7B进行了比较,发现这两个模型的性能非常相似。Alpaca在与GPT-3.5的比较中,获胜次数为90对89。

重点来了:这些开源模型,究竟是怎么做到这点的?

斯坦福团队的答案是两点:1、一个强大的预训练语言模型;2、一个高质量的指令遵循数据。

动态 | 日本经济产业省发布“大学、研究机构采用区块链技术的可能性”主题报告:据日本经济产业省官网消息。4月23日,日本经济产业省发布了以“大学、研究机构采用区块链技术的可能性”为主题的调查报道。 报告提到,虽然区块链技术仍处于发展之中,但其可以根据需要应用于各个领域,有必要分析该技术投入实用的需求和问题,并确保区块链的持久性。在“学位、履历管理”领域,区块链技术可用于“正确核实任何已不复存在的发行人过去曾签发的证书”,这在现有制度下是很难做到的。而在“研究数据可信度担保”领域,海内外已有一些组织正运行着具有一定可性度的中心化系统,只要这些系统具有成本优势且功能正常,就没有必要强行应用区块链技术。 报告总结到,随着(日本)加密货币交易市场的日益活跃,以金融机构为中心的区块链技术应用研究开发、技术实验也日趋活跃。从国际竞争力的角度考虑,有必要稳步发展区块链技术,并将标准化工作与推广切实联系起来。[2019/4/23]

在这里,我们将强大的预训练语言模型,比喻为一位有着丰富知识和经验的老师。

对于自然语言处理领域的任务,强大的预训练语言模型,可以利用大规模的文本数据进行训练,学习到自然语言的模式和规律,并且可以帮助指令遵循等任务的模型更好地理解和生成文本,提高模型的表达和理解能力。

这就相当于学生使用老师的知识和经验,来提高语言能力,指令遵循等任务的模型可以使用预训练语言模型的知识和经验来提高自己的表现。

康奈尔大学区块链研究人员预测:EOS的脆弱性将导致“大规模的交易所攻击”:据CCN消息,康奈尔大学的教授Emin Gün Sirer发推称,“明年将会有一场大规模利用EOS漏洞的黑客攻击,如果EOS使用其仲裁人来逆转黑客攻击,其危机将蔓延至下游。将会有涉及开发人员和区块生产商的诉讼威胁。”Emin Gün Sirer还补充到,“考虑到开发人员处理关键安全问题的方式,出现这一攻击将很可能是不可避免的。”[2018/6/19]

除了借助这位“老师”的知识外,开源模型的另一“利刃”,就是指令微调。

指令微调,或指令调优,是指现有的大语言模型生成指令遵循数据后,对数据进行优化的过程。

具体来说,指令微调是指在生成的指令数据中,对一些不合适或错误的指令进行修正,使其更符合实际应用场景。

而指令调优是指在生成的指令数据中,对一些重要、复杂或容易出错的指令进行加重或重复,以提高指令遵循模型对这些指令的理解和表现能力。

凭借着这样的“微调”,人们可以生成更准确、更有针对性的指令遵循数据,从而提高开源模型在特定任务上的表现能力。

国家环境保护污染源监测工程技术中心使用区块链开发“大气110”平台: 4月19日,“第二十二届大气污染防治技术研讨会”在山西太原召开,中组部“千人计划”专家、国家环境保护污染源监控工程技术中心主任李玮的主题报告《云+链,开启环保大格局》引起全场专家热议。李玮提出要通过“管理上云,服务上链”,实现数据的互联互通、开放共享,从而更好的推进环境管理转型,提升生态环境治理能力。另外,由李玮团队研发的全国“大气110平台”在会上首次亮相,引起多位专家学者的关注。作为国家重大专项重要成果,“大气110”平台由国家环境保护污染源监控工程技术中心使用“云链”技术开发,会议现场,与会人员扫描二维码注册后,切身体验生态大数据的魅力。[2018/4/20]

如此一来,即使只用很少的数据,开源社区也能训练出性能匹敌ChatGPT的新模型。

然而,又一个问题是:面对自己辛苦打下的江山,被开源社区用“四两拨千斤”的方式步步蚕食,谷歌和OpenAI为何一直没有予以反制呢?

哪怕是如法炮制,以攻,推出同样快速迭代的小模型,也不失为一种破局之策啊。

02骑虎难下

实际上,谷歌这样的头部企业,不是没有意识到开源的优势。

在那份泄漏的文件中,谷歌就提到:几乎任何人都能按照自己的想法实现模型微调,到时候一天之内的训练周期将成为常态。以这样的速度,微调的累积效应将很快帮助小模型克服体量上的劣势。

可问题是,身为AI领域巨头的谷歌和OpenAI,既不能,也不愿完全放弃训练成本高昂的大参数模型。

从某种程度上说,这是其保证自身优势地位的必要手段。

作为AI领域的巨头,谷歌和OpenAI需要不断提升自己的技术实力和创新能力。而传统的大参数训练模型,则是提供这一探索和创新的必经之路。

因为大模型的底层技术若想取得突破,AI领域的研究者和科学家,就需要更深入地理解模型和算法的基本原理,探索AI技术的局限性和发展方向,这需要进行大量的理论研究、实验验证和数据探索,而不仅仅是微调和优化。

例如,在训练大参数模型时,AI领域的科学家,可以探索模型的泛化能力和鲁棒性,在不同的数据集和场景下评估模型的性能和效果。谷歌的BERT模型,也正是在此过程中得到了不断强化。

同时,大参数模型的训练,还可以帮助科学家探索模型的可解释性和可视化,

例如,对今天的GPT来说至关重要的Transformer模型,虽然在性能上表现出色,但其内部结构和工作原理却相对复杂,不利于理解和解释。

通过大参数模型的训练,人们可以可视化Transformer模型的内部结构和特征,从而更好地理解模型是如何对输入进行编码和处理的,并进一步提高模型的性能和应用效果。

因此,开源和微调的方式,虽然可以促进AI技术的快速发展和优化,但不足以替代对AI基础问题的深入研究和探索。

但话说到这,一个十分尖锐的矛盾又摆了出来:一方面,谷歌和OpenAI不能放弃对大参数模型的研究,并坚持对其技术进行保密。但另一方面,免费、高质量的开源替代品,又让谷歌等大厂的“烧钱”策略难以为继。

因大模型耗费的巨大算力资源和数据,仅是在2022年,OpenAI总计花费就达到了5.4亿美元,与之形成鲜明对比的,则是其产生的收入只有2800万美元。

与此同时,开源社区的具有的灵活性上的优势,也让谷歌等大厂感到难以匹敌。

在那份泄漏的文件中,谷歌就认为:开源阵营真正的优势在于“个人行为”。

相较于谷歌这些大厂,开源社区的参与者可以自由地探索和研究技术,不受任何限制和压力,从而有更多机会发现新的技术方向和应用场景。

而谷歌研究和开发新技术时,则必须考虑产品的商业可行性和市场竞争力。这就对人才的研究方向产生了一定的限制和约束。

此外,由于保密协议的存在,谷歌的人才也难以像开源社区那样,与外界充分地交流和分享技术研究的成果。

如果说,低价、灵活的开源模型,终将成为一种不可阻挡的趋势,那么当谷歌等大厂面对这浩瀚的战场时,又该怎样在新时代生存下去呢?

03另辟蹊径

倘若谷歌这样的头部企业,最终在开源阵营的攻势下,选择了“打不过就加入”的策略,那如何在开源的情况下,找到一条可行的商业路径,就成了一件头等大事。

毕竟,在目前的市场认知下,开源几乎就等于“人人皆可免费使用。”

之前,StableDiffusion背后的明星公司——StabilityAI,就因为在开源后,没有找到明确的盈利途径,目前正面临严重的财政危机,以至于到了快倒闭的地步。

不过,关于如何在开源的情况下实现盈利,业界也不是完全没有先例可循。

例如,之前谷歌对Android系统的开源,就是一个经典的案例。

当年,由谷歌主导开发和推广的Android系统开源后,谷歌仍然通过各种途径,从Android操作系统的设备制造商那里获取了收益。

具体来说,这些途径可分为以下几种:

1.收取授权费用:当设备制造商希望在其设备上预装GooglePlay商店等谷歌应用和服务时,他们需要遵守谷歌的授权协议,并支付相应的授权费用。

2.推出定制设备:谷歌通过与设备制造商合作,推出一些定制的Android设备,如GooglePixel智能手机和GoogleNexus平板电脑等,并从中获得收入。这些定制设备通常具有更高的价值和更好的性能,而且会预装谷歌的应用和服务。

3.销售应用:当设备使用者在GooglePlay商店中购买应用、游戏或媒体内容时,谷歌会从中提取一定的佣金。

虽然这些途径的收益,也许并不像谷歌的主业——搜索和广告那样让其赚得盆满钵满,但谷歌仍然从中获得了各种“隐性收益”。

因为Android的存在,避免了某一家企业垄断移动平台的入口,只要互联网是开放的,谷歌就能通过吸引更多人使用Android上的应用,来收集用户的行为数据,对这些数据进行加工,从而使得广告投放可以更加精准。

由此可见,开源模式并非与商业化的盈利模式完全冲突,这对于谷歌和开源社区的参与者而言,都是一种好事。

因为只有通过商业化途径,源源不断地为自身“造血”,谷歌和OpenAI等大厂,才能继续承担起训练大参数模型所需的巨额成本。

而只有大参数模型的持续研发,各大开源社区,才能继续以高性能、高质量的预训练语言模型为基础,微调出种类更多,应用场景更为丰富的开源模型。

基于这样的关系,开源模型与封闭的大模型之间,其实不仅仅只是对立与竞争,同时也是一种互助共生的生态。

作者:英国税务总署金融服务近年来迅猛发展,其中包括加密资产的增长。新形式的加密资产和由它们支持的服务正在不断发展。2018年3月,时任财政大臣推出了政府的金融科技行业战略.

1900/1/1 0:00:004月份上海升级的完成使得质押的ETH可赎回,进而使LSD赛道变的完整起来。据21Shares研究分析师TomWan发推分析,以太坊信标链上的待定验证者数量已达到3.345万,创下历史新高,表明大.

1900/1/1 0:00:00重点①埃隆·马斯克始终被视为特斯拉的象征,其重点多关注技术和工程领域,因此这家电动汽车制造商需要有个真正的幕后掌舵人,他就是首席财务官扎克·柯克霍恩.

1900/1/1 0:00:00投资风投基金PanteraCapital发推表示反对Compound第32号治理提案,该提案要求将COMP分发给2020年11月25日受DAI清算影响的用户,作为补偿.

1900/1/1 0:00:00金色周刊是金色财经推出的一档每周区块链行业总结栏目,内容涵盖一周重点新闻、行情与合约数据、矿业信息、项目动态、技术进展等行业动态。本文是项目周刊,带您一览本周主流项目以及明星项目的进展.

1900/1/1 0:00:00这是“牛市”,每天都有更多的人开始了解加密货币,包括机构投资者、小企业和散户投资者。?Piplsay最近对6070名英国人围绕比特币进行了一项调查,其中有23%的人表示愿意购买加密货币.

1900/1/1 0:00:00