来源:机器之心

纯文本大模型方兴未艾,多模态领域也开始涌现出多模态大模型工作,地表最强的GPT-4具备读图的多模态能力,但是迟迟未向公众开放体验,于是乎研究社区开始在这个方向上发力研究并开源。MiniGPT-4和LLaVA问世不久,阿里达摩院便推出mPLUG-Owl,一个基于模块化实现的多模态大模型。

今天要介绍的是mPLUG-Owl,该工作不仅通过大量cases展示出优秀的多模态能力,还第一次针对视觉相关的指令理解提出一个全?的测试集OwlEval,通过人工评测对比了已有模型,包括LLaVA、MiniGPT-4、BLIP-2以及系统类MM-REACT等工作,实验结果表明mPLUG-Owl展示出更优的多模态能力,尤其在多模态指令理解能力、多轮对话能力、知识推理能力等方?表现突出

福布斯:以太坊上海升级后将有价值290亿美元的ETH被解锁:2月13日消息,据福布斯报道,根据数据提供商Staking Rewards的数据,目前约有14%的ETH被质押,市值约为290亿美元。而在上海升级后,用户将可以提取这些资产。鉴于资产已被长期锁定以及加密市场悬而未决的不确定性,人们担心许多验证者会撤回并出售他们抵押的以太坊,这可能会给以太坊的价值带来压力。

据Galaxy Digital称,以太坊上至少75%的质押ETH由中介机构控制,例如 Coinbase或Kraken等交易所,或Lido或Rocketpool等特殊平台,这意味着绝大多数抵押者不会能够直接发起自己的取款。预计大部分提款将来自以太坊最大的质押平台Lido,该平台允许用户质押任意数量的以太币,而不是32 ETH的门槛。而Staking Rewards研究主管Allan Wojnowski表示:“排队过程和Lido的大量提款份额将大大减缓提款过程中的任何抛售压力,因为在提现功能存在之前就需要有信心押注以太坊,早期的质押者不太可能寻求退出,而且尽管有报道预测会出现大量提现,但平均每天仍有20,800枚ETH继续质押。”质押中介机构可能会获得巨大收益,摩根大通(JPMorgan)估计,在上海升级后,Coinbase 95%的散户投资者可能会参与质押以太坊,按当前价格计算,这可能会给交易所带来2.25亿至5.45亿美元的年收入。

此前金色财经报道,2月7日以太坊首个公共提款测试网Zhejiang已成功模拟上海升级,公共测试网Sepolia计划于2月28日升级,之后计划在2月底或3月初在以太坊Goerli测试网上发布上海升级,过渡成功后,将转向主网。[2023/2/13 12:03:10]

NFT市场SuperRare将裁员30%:1月7日消息,NFT市场SuperRare首席执行官John Crain宣布,SuperRare将裁员30%,并表示最近几个月NFT市场激进增长正变得不可持续,由于此前过度招聘,因此他个人将“对这个错误负全部责任”。

不过,John Crain强调Web3、NFT、加密艺术、去中心化金融和治理方面还有很多创新和转型尚未到来,尽管现在正面临逆风,但加密市场仍有难以置信的机会。(TechCrunch)[2023/1/7 10:59:48]

论文链接:https://arxiv.org/abs/2304.14178

代码链接:https://github.com/X-PLUG/mPLUG-Owl

ModelScope体验地址:

https://modelscope.cn/studios/damo/mPLUG-Owl/summary

HuggingFace体验地址:

https://huggingface.co/spaces/MAGAer13/mPLUG-Owl

Nomad发布跨链桥重启指南,已启动KYC验证:12月8日消息,跨链互操作性协议Nomad发布跨链桥重启指南,目前已启动KYC验证。跨链和铸造NFT功能暂不可用。[2022/12/8 21:31:18]

多模态能力展示

我们把mPLUG-Owl与现有工作进行对比来感受一下mPLUG-Owl的多模态效果,值得一提的是,该工作中评比的测试样例基本上都来自已有工作,避免了cherrypick问题。

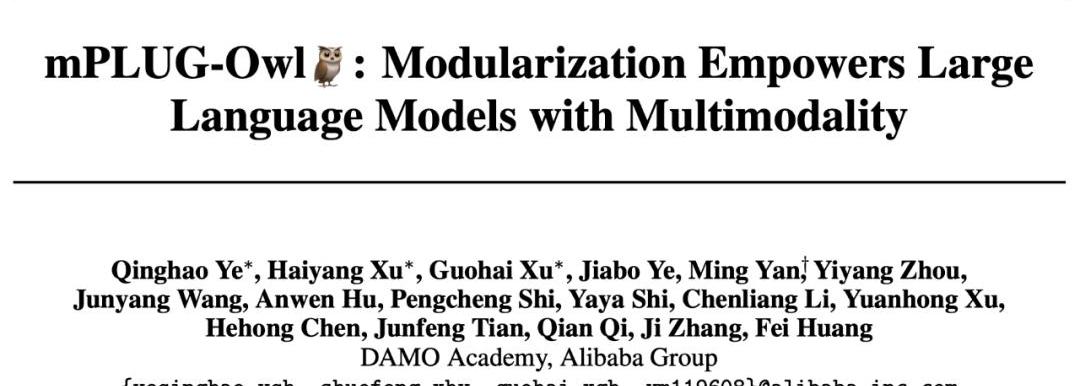

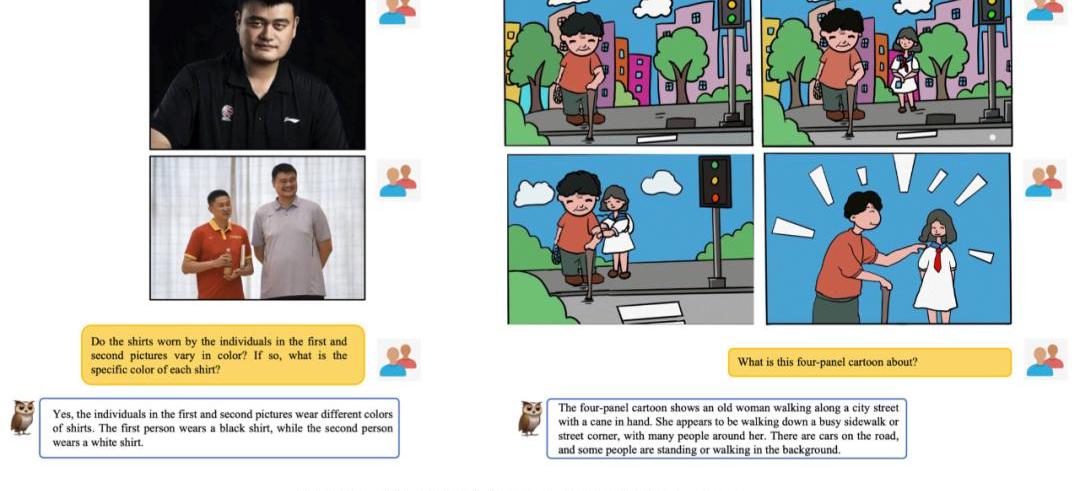

下图6展示了mPLUG-Owl很强的多轮对话能力。

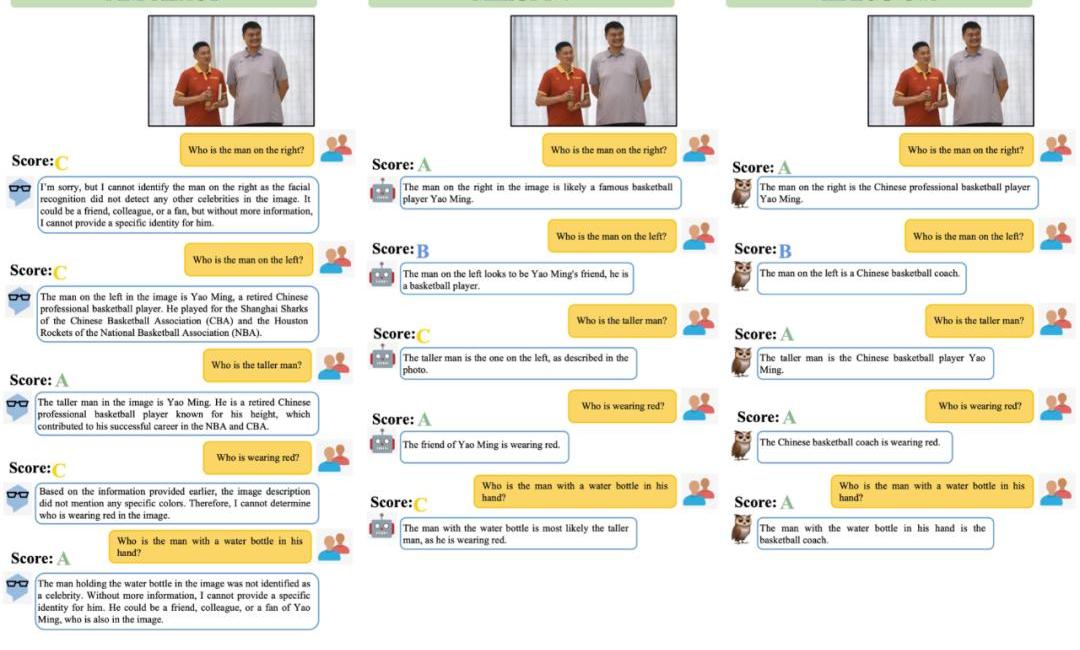

从图7中可以发现,?mPLUG-Owl具有很强的推理能力。

BurnBNB:BEP-95升级后已销毁129000枚BNB:金色财经报道,BurnBNB发推特表示,自BEP-95实时销毁升级以来,已经销毁了129,000枚BNB(价值50,122,100美元)。[2022/10/26 16:38:57]

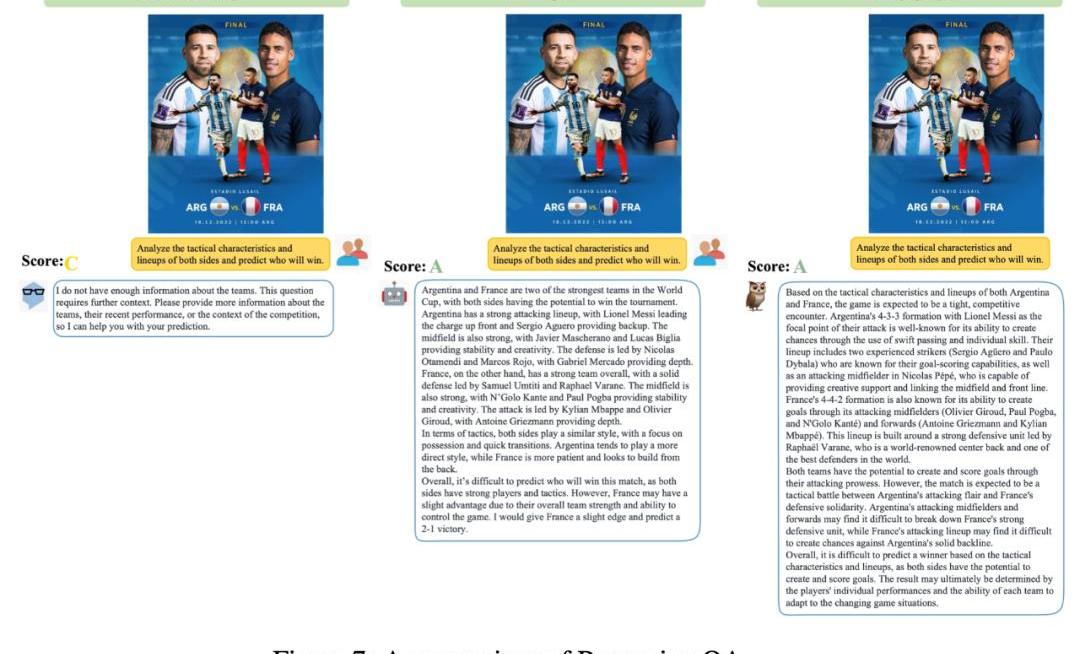

如图9展示了一些笑话解释例?。

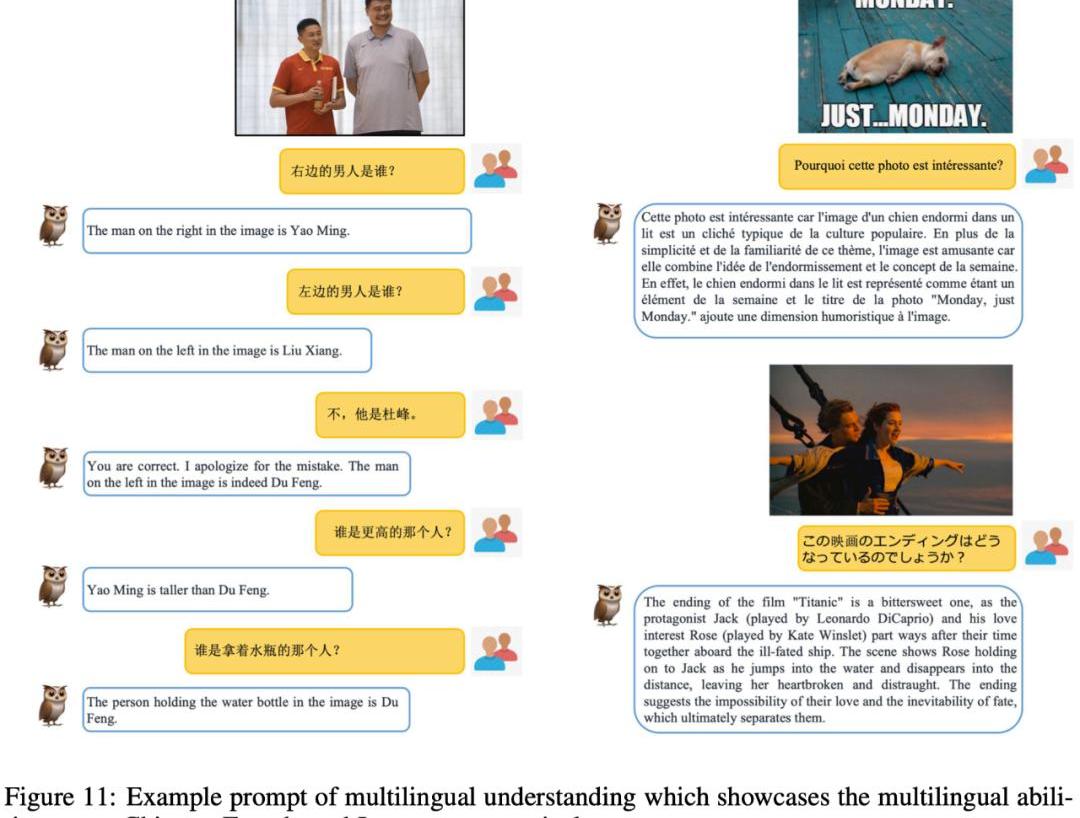

在该工作中,除了评测对比外,该研究团队还观察到mPLUG-Owl初显一些意想不到的能力,比如多图关联、多语?、文字识别和文档理解等能力。

如图10所示,虽然在训练阶段并没有进行多图关联数据的训练,mPLUG-Owl展现出了一定的多图关联能力。

Celsius官方澄清:团队与CEL2.0代币的创建无关:金色财经报道,Celsius官方发推称,为了避免混淆,CelsiusNetwork澄清,CelsiusNetwork与任何所谓的CEL2.0代币的创建都没有关系。我们的安全团队正处于警戒状态,投资者也应该保持警惕。[2022/6/14 4:24:21]

如图11所示,尽管mPLUG-Owl在训练阶段仅使用了英文数据,但其展现出了有趣的多语?能力。这可能是因为mPLUG-Owl中的语?模型使用了LLaMA,从而出现了这一现象。

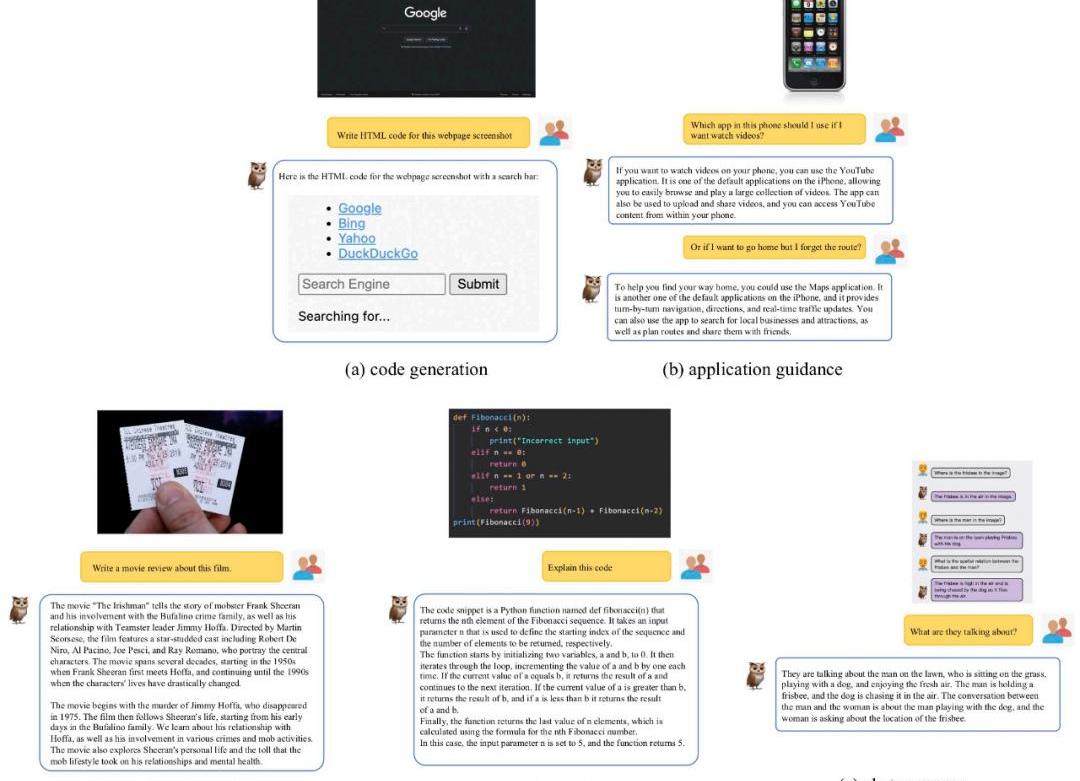

尽管mPLUG-Owl没有在带有标注的文档数据上进行训练,但其仍然展现出了一定的文字识别和文档理解能力,测试结果如图12所示。

方法介绍

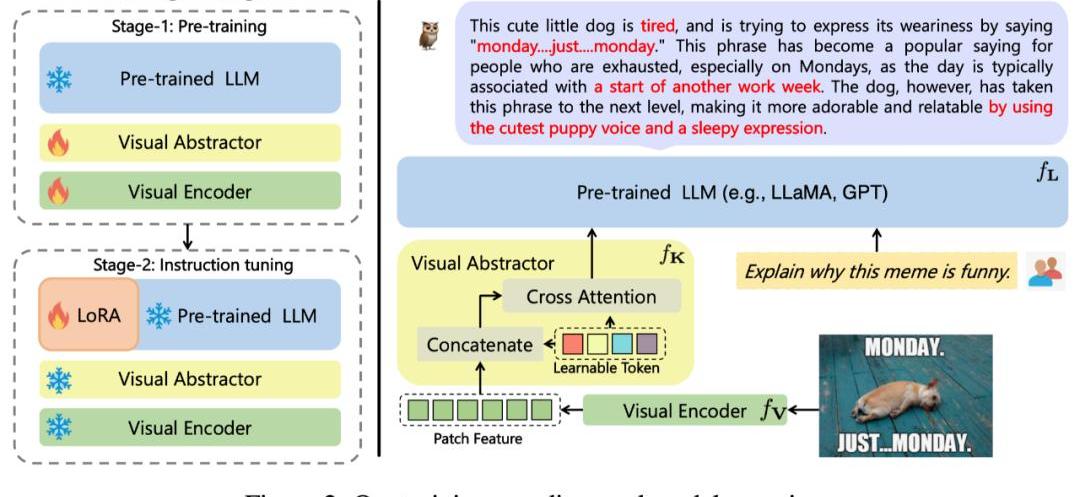

该工作提出的mPLUG-Owl,其整体架构如图2所示。

模型结构:它由视觉基础模块(开源的ViT-L)、视觉抽象模块以及预训练语?模型(LLaMA-7B)组成。视觉抽象模块将较?的、细粒度的图像特征概括为少量可学习的Token,从而实现对视觉信息的?效建模。?成的视觉Token与文本查询一起输?到语?模型中,以?成相应的回复。

模型训练:采用两阶段的训练方式

第一阶段:主要目的也是先学习视觉和语?模态间的对?。不同于先前的工作,?mPLUG-Owl提出冻住视觉基础模块会限制模型关联视觉知识和文本知识的能力。?因此mPLUG-Owl在第一阶段只冻住LLM的参数,采用LAION-400M,?COYO-700M,?CC以及MSCOCO训练视觉基础模块和视觉摘要模块。

第?阶段:延续mPLUG和mPLUG-2中不同模态混合训练对彼此有收益的发现,Owl在第?阶段的指令微调训练中也同时采用了纯文本的指令数据(52kfromAlpaca+90kfromVicuna+50kfromBaize)和多模态的指令数据(150kfromLLaVA)。作者通过详细的消融实验验证了引?纯文本指令微调在指令理解等方?带来的收益。第?阶段中视觉基础模块、视觉摘要模块和原始LLM的参数都被冻住,参考LoRA,只在LLM引?少量参数的adapter结构用于指令微调。

实验结果

SOTA对比

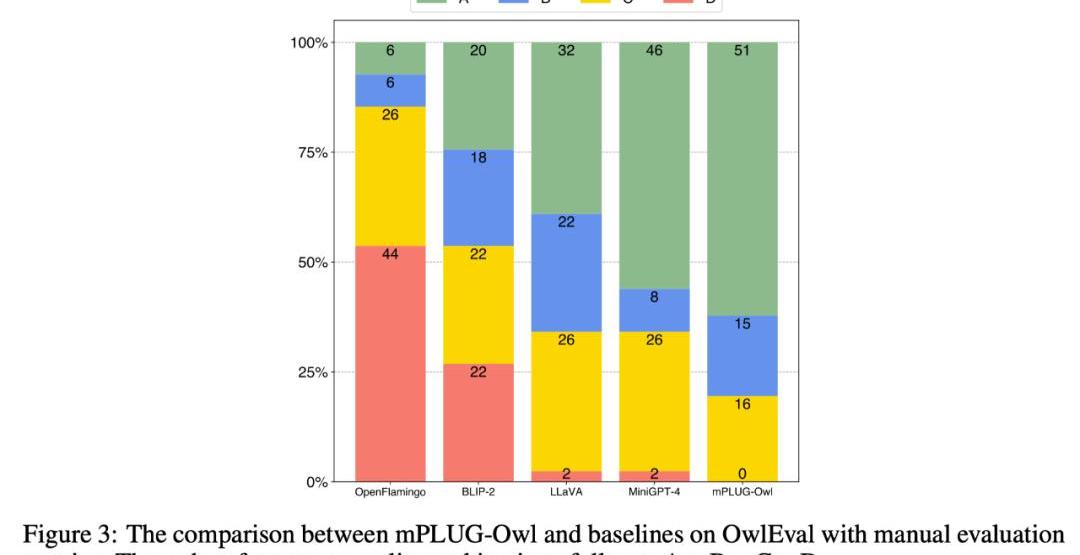

为了比较不同模型的多模态能力,该工作构建一个多模态指令评测集OwlEval。由于?前并没有合适的自动化指标,参考Self-Intruct对模型的回复进行人工评测,打分规则为:A="正确且令人满意";B="有一些不完美,但可以接受";C="理解了指令但是回复存在明显错误";D="完全不相关或不正确的回复"。

对比结果如下图3所示,实验证明Owl在视觉相关的指令回复任务上优于已有的OpenFlamingo、BLIP-2、LLaVA、MiniGPT-4。

多维度能力对比

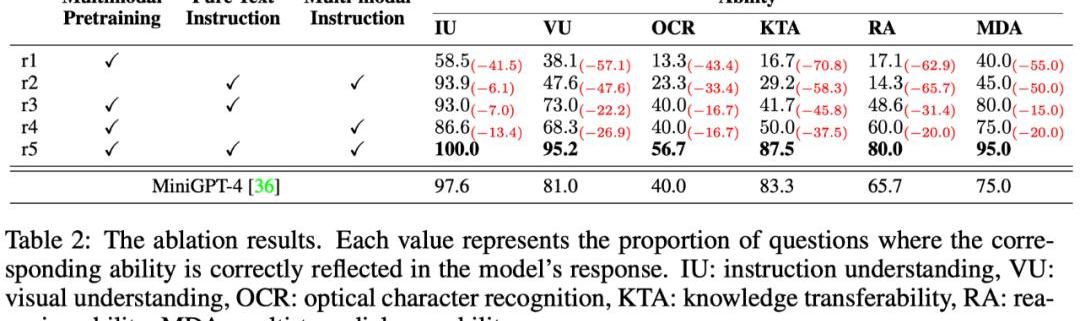

多模态指令回复任务中牵扯到多种能力,例如指令理解、视觉理解、图?上文字理解以及推理等。为了细粒度地探究模型在不同能力上的?平,本文进一步定义了多模态场景中的6种主要的能力,并对OwlEval每个测试指令人工标注了相关的能力要求以及模型的回复中体现了哪些能力。

结果如下表格6所示,在该部分实验,作者既进行了Owl的消融实验,验证了训练策略和多模态指令微调数据的有效性,也和上一个实验中表现最佳的baseline—MiniGPT4进行了对比,结果显示Owl在各个能力方?都优于MiniGPT4。

每年一度的「meme季」它又又又又来了。这是一个充满焦虑的「季节」。财富自由的故事似乎在不断发生,害怕没能「上车」的FOMO情绪能够战胜所有未知的恐惧。这是一个自我怀疑的「季节」.

1900/1/1 0:00:00来源丨元宇宙简史编写丨元宇宙简史主理人FunOpenAI近日发布条件生成模型Shap-E,可用来生成3D资产。据悉,该模型不像传统模型只是产生一个单一的输出表示,Shap-E生成隐含函数的参数.

1900/1/1 0:00:00本文来自:Blockworks编译:Odaily星球日报Azuma 有着“木头姐”称呼的女股神CathieWood一直以来都是华尔街最大的?Crypto多头之一.

1900/1/1 0:00:00原文来源于Dappradar,白泽研究院编译。因篇幅原因略有内容删改,建议感兴趣的读者阅读原文:https://dappradar.com/blog/yuga-labs-from-nothing.

1900/1/1 0:00:001.a16z近期投资项目一览跟随smartmoney投资很重要。加密领域的一大smartmoney就是a16z.

1900/1/1 0:00:00前两天,Sui主网正式上线。新上任的Sui基金会董事总经理GregSioourounis表示,“对于整个Sui社区和整个数字资产生态系统来说都是一个里程碑……为世界各地的用户解锁了无限的可能性.

1900/1/1 0:00:00