原创:陈彬

来源:远川研究所

图片来源:由无界AI工具生成

每一个大模型都是一台昂贵的“碎钞机”,这已经成为各路AI观察家们津津乐道的常识。

大模型训练成本有一个简单的比例:训练费用跟参数量的平方成正比。比如OpenAI训练1750亿参数的GPT-3费用大概是1200万美元,训练5000亿参数的GPT-4成本就飙升至1亿美元。

成本大都来自GPU使用时长。Meta训练650亿个参数的LLaMA模型耗费100万个GPU小时;HuggingFace训练Bloom模型耗费了超过两个半月的时间,使用的算力相当于一台装有500个GPU的超级计算机。

Google在训练5400亿参数的PaLM模型时,在6144块TPUv4芯片上训练了1200小时,然后又在在3072块TPUv4芯片上训练了336小时,总共消耗了2.56e24FLOPs的算力,折合成Google云计算的报价,大概在900~1700万美元左右。

但是……几百上千万美金的训练费用和几亿美金的硬件投入,相比AIGC开启的浪潮,真的算贵吗?

微软2022年的净利润是727亿美金,Google是600亿美金,Meta则是230亿美金,在OpenAI花费460万美金训练GPT-3之前,这些巨头都投入了几十甚至上百亿美金用来寻找所谓的“新方向”。

微软迄今为止向OpenAI投入了100多亿美金,这个数字看起来很多,但要知道微软当年收购LinkedIn就花了262亿美金,而在更早的时候收购诺基亚手机业务花了71.7亿美金,基本等于打了水漂。

Meta则花了更多“冤枉钱”来寻找第二曲线。2021年扎克伯格把Facebook的名字改成了“Meta”,投入巨资Allin元宇宙,2022年元宇宙部门亏损137亿美元。在ChatGPT问世之前,Meta甚至一度准备把2023年的20%预算投入到元宇宙中去。

Google对AI一向重视,不仅收购了“前GPT时代”的明星DeepMind,还是Transformer这一革命性模型的提出者,但Google并没有像OpenAI那样孤注一掷地“死磕”大语言模型,而是在多个方向上“撒胡椒面”——总投入并不少,但效果加起来都不如一个ChatGPT。

预言机DIA拟将3万枚ARB用于资助在Arbitrum上运行预言机所需的Gas费:6月9日消息,预言机DIA在社区提交一份题为《Oracle Gasdrop——一项通过Oracle Gas资金支持Arbitrum生态系统发展的资助计划》的提案,旨在通过提供赠款来资助在Arbitrum上运行预言机所需的Gas费,支持Arbitrum生态系统中新的DeFi项目的开发。

DIA表示,近期在Arbitrum空投中收到7.5万枚ARB,建议将其中3万枚ARB用来支持Arbitrum开发者。任何在Arbitrum网络上运行并需要Gas费来资助DIA预言机的项目都可以提交申请,其他规定将在适当的时候具体说明。审批机制将通过DIA的Snapshot投票系统进行操作,合格的投票者包括申请项目、DIA与Arbitrum的代币持有者。获得所需票数的项目将被授予1000枚ARB,并只能用于为DIA预言机提供Gas费。

该提案称,DIA DAO 可以在 6 月 15 日前提出其他替代方案来使用空投收到的 ARB,并将于 6 月 16 日使用 Snashot 平台进行投票,6 月 21 日公布投票结果。[2023/6/9 21:26:58]

拉开视野来看,全球科技巨头——包括国内的大型互联网企业在移动互联网渗透率见顶之后,展开了惨烈的“存量博弈”,卷算法推荐、卷短视频、卷Web3、卷本地生活……投入的资金远远超过OpenAI在ChatGPT诞生前烧掉的10亿美金。

发现新大陆的费用,跟旧大陆的内耗向来不在一个数量级。欧洲人在哥伦布发现新大陆之前内卷了1000年,而发现新大陆只花了西班牙王室投资的200万马拉维迪——跟新大陆给世界带来的变化相比,这点儿钱其实微不足道。

事实上,“资金”从来都不是启动本轮AI浪潮的核心因素。真正核心的因素是另外两个字:信仰。

蛮力的神迹

ChatGPT走红后,好事儿的媒体跑去采访了Google旗下的DeepMind创始人DemisHassabis。

被OpenAI抢去了所有风头的Hassabis言辞有点儿不客气:“面对自然语言这一挑战,ChatGPT的解决方案如此不优雅——仅仅是更多的计算能力和数据的蛮力,我的研究灵魂对此倍感失望。”

NFT永续合约交易平台nftperp宣布启动DAO治理:5月2日消息,NFT 永续合约交易平台 nftperp 宣布启动 DAO 治理,由于协议治理 Token NFTP 尚未发布,目前暂时使用不可转让的 VNFTP 作为治理 Token,VNFTP 可在 NFTP 发布后 1:1 进行置换。

同时,团队发布社区首个提案以启动 DAO 治理模式,VNFTP 持有者可对此提案进行投票表决。[2023/5/3 14:39:20]

DemisHassabis和柯洁

这句话听起来很“酸”,然而他接着话锋一转:“但这的确是获得最佳结果的方式,所以我们也以此为基础。”意思就是虽然不太认同,但OpenAI的“蛮力”真的很香,我们也不得不去学。

Hassabis身段灵活,但早期对“蛮力”这件事的态度,让Google和OpenAI有了致命的分野。

2017年,谷歌在论文中公开了革命性的Transformer模型,业界逐渐意识到这个模型对于构建AGI的意义。然而,基于同样的Transformer,谷歌与OpenAI却走上了两条不同的两条路。

OpenAI旗帜鲜明地从Transformer构建大语言模型,疯狂堆参数,2018年6月发布GPT-1,参数1.17亿;2019年2月发布GPT-2,参数15亿;2020年5月发布GPT-3,参数1750亿,在蛮力的道路上“一条路走到黑”。

而Google虽然也地祭出BERT、T5和SwitchTransformer,表面上跟OpenAI斗的有来有回,但光从模型的名字就能看出来:Google总在更换模型搭建的策略,而OpenAI的策略更单一更专注。

比如GPT-2和GPT-1相比,OpenAI没有重新设计底层结构,而是将Transformer堆叠的层数从12层增加到48层,并使用了更大的训练数据集,而GPT-3进一步把层数增加到了96层,使用比GPT-2还要大的数据集,但模型框架基本上没有改变。

另外,基于Transformer的大模型演化有三个分支:EncoderOnly,Encode-Decoder,DecoderOnly。OpenAI一直坚持只用DecoderOnly方案,而Google则变来变去:BERT模型使用EncoderOnly,T5模型又改成了Encode-Decoder。

等到OpenAI突破后,Google匆忙转向DecoderOnly方案,时间已经错失了至少一年半。

欧盟官员:欧盟议会的智能合约计划限制了统一标准制定:3月15日消息,欧盟内部市场专员Thierry Breton周二告诉记者,欧盟有争议的规定要求对某些智能合约设置“终止开关”,这可能会限制为该行业设定标准的关键能力。

他的言论暗示,议员们当天早些时候投票通过的条款不再符合2022年委员会法律提案“数据法案”(Data Act)中设定的目标。

Breton称:“我们需要协调这些智能合约的基本要求,以确保互操作性、法律确定性和大规模部署,当提出这个提案时,我们打算要求相关组织制定这些标准。”

“我注意到议会提议修改这些基本要求,”他说,“值得注意的是,这些变化可能会限制制定智能合约统一标准的可能性。”(CoinDesk)[2023/3/15 13:05:25]

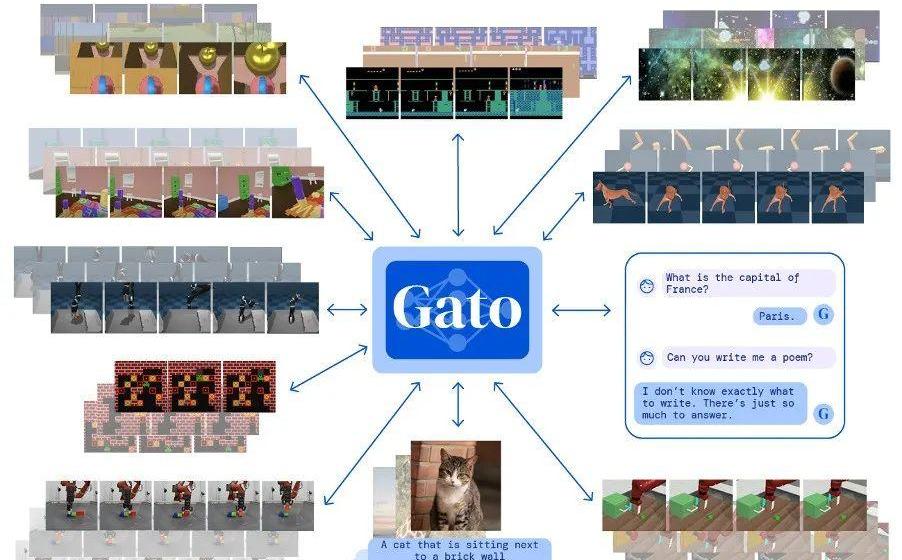

在跟OpenAI的军备竞赛中,Google却总沉浸在一些貌似炫酷,但实则对AI缺乏信心的产品上——比如2022年发布的Gato。Gato的思路是先做一个大模型底座,然后再灌不同的数据,以此生成出大量小模型——每个小模型都有特定的能力。

这么做的目的是让单个AI具备尽可能多的功能,更加通用。做一个简单的类比:谷歌路线相当于让一个上完九年义务教育的12岁小孩儿,去参加钢琴、写作、编程、舞蹈等一系列专业技能培训班,靠着“1+1+1...”培养出一个多才多艺的“全才”。

Gato能执行604种不同的任务,包括给图片配文、玩雅达利游戏、操作机械臂搭积木。不过,Gato虽做到了“通才”,但实用性却相当堪忧:其中近一半功能,还不如便宜小巧的“专才AI”好使,有媒体评价:一个平庸的人工智能。

“万能”但又不那么万能的Gato

相比之下,OpenA更热衷于让AI“做好一件事”,即像人类一样理解自然语言——这是通向AGI的必经之路。

在所有站在Transformer模型肩膀上的团队中,OpenAI是把“蛮力”发挥到最淋漓尽致的一个,算力不够就买算力,数据不够就找数据,别人的牛逼技术我直接拿来用,反正就是要把规模堆上去。终于,在“暴力美学”的指引下,奇迹出现了。

The Sandbox宣布与日本动画制作公司东映动画达成合作:金色财经报道,据官方推特,The Sandbox宣布与日本最大、历史最悠久的动画制作公司之一东映动画公司(TOEI ANIMATION CO., LTD.)、以及NFT漫画平台Minto达成合作。

The Sandbox将把东映动画公司的标志性动画角色IP带入元宇宙并推出独家NFT,东映动画旗下动漫作品包括《北斗神拳》、《龙珠》、《灌篮高手》、《海贼王》等。[2023/2/17 12:12:17]

从成立第一天起,OpenAI就把创造接近甚至超越人类的AGI作为几乎唯一的目标。而且相比Google的迟疑不定,OpenAI发起人们是真的相信AI可以成为一个18岁的成年人,而不是永远停留在12岁上打转。

黄仁勋在今年3月对谈OpenAI联合创始人IlyaSutskever时,问了一个问题:“在这个过程中,你一直相信,扩大规模会改善这些模型的性能吗?”Ilya回答道:“这是一个直觉。我有一个很强烈的信念,更大意味着更好。”

这是一场蛮力的胜利,但更是一种信仰的胜利。大模型回报给“信仰”的礼物,也远超想象——随着参数量的暴力提升,研究人员突然有一天发现大模型出现了令人惊喜,但又难以解释的能力飙升。

他们找了一个老词来形容这种现象:Emergence。

虔诚的回报

Emergence这个词,常见于哲学、系统学、生物学等领域,其经典的定义是:当一个实体被观察到具有各个部分单独存在时不具备的属性和能力时,这种现象就被称之为“涌现”,早在古希腊时代,这种现象就被亚里士多德研究过。

后来,英国哲学家GeorgeLewes在1875年第一次发明了Emergence这个词,用来专门形容上述现象。1972年,诺贝尔物理学奖得主PhilipAnderson撰写了一篇名叫“MoreisDifferent”的文章,用一句经典的金句来给“涌现”做了解释:

当一个系统的量变导致质变时,就称之为“涌现”。

“涌现”被引入到大模型中,可以说是相当贴切:AI工程师们观察到一个现象,随着模型的参数量越来越大,当超过某个阈值或者“临界点”的时候——比如参数量达到100亿,模型会出现一些让开发者完全意想不到的复杂能力——比如类似人类的思维和推理能力。

比如,Google大模型测试基准BIG-Bench里有一项任务:给出4个emoj表情符号,让模型回答代表什么电影。简单和中等复杂度的模型都回答错了,只有参数超过100亿的大模型会告诉测试者:这是电影FindingNemo。

YOLO Bunny #9555以100 ETH成交,创该系列迄今美元交易最高记录:金色财经报道,据最新交易数据显示,YOLO Bunny #9555以100 ETH的价格成交,约合161,380.11美元,创下该NFT系列迄今美元交易最高记录。YOLO Bunny NFT系列由Web3.0音乐元宇宙平台Muverse推出,总计包含9,999只来自1,402号宇宙的兔子音乐艺术家&爱好者,7月27日YOLO Bunny #3839也以100 ETH价格成交,当时交易额约合142,094.71美元。[2022/7/29 2:44:50]

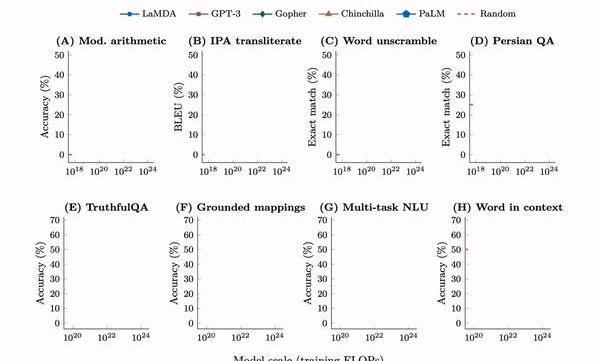

2022年,来自Google、DeepMind、斯坦福和北卡莱罗纳大学的学者分析了GPT-3、PaLM、LaMDA等多个大模型,发现随着训练时间、参数量和训练数据规模的增加,模型的某些能力会“突然”出现拐点,性能肉眼可见地骤然提升。

这些“涌现”能力超过了137多种,包括多步算术、词义消歧、逻辑推导、概念组合、上下文理解等。这项研究给大模型的“涌现”下了一个定义:如果一项能力只有在大模型中存在,在小模型中观测不到,这项能力就是“涌现”出来的。

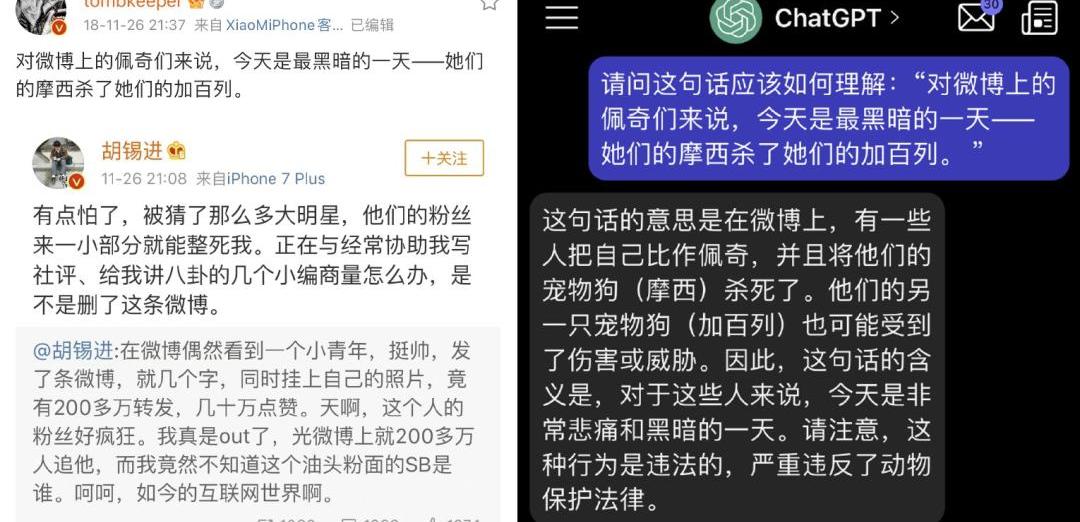

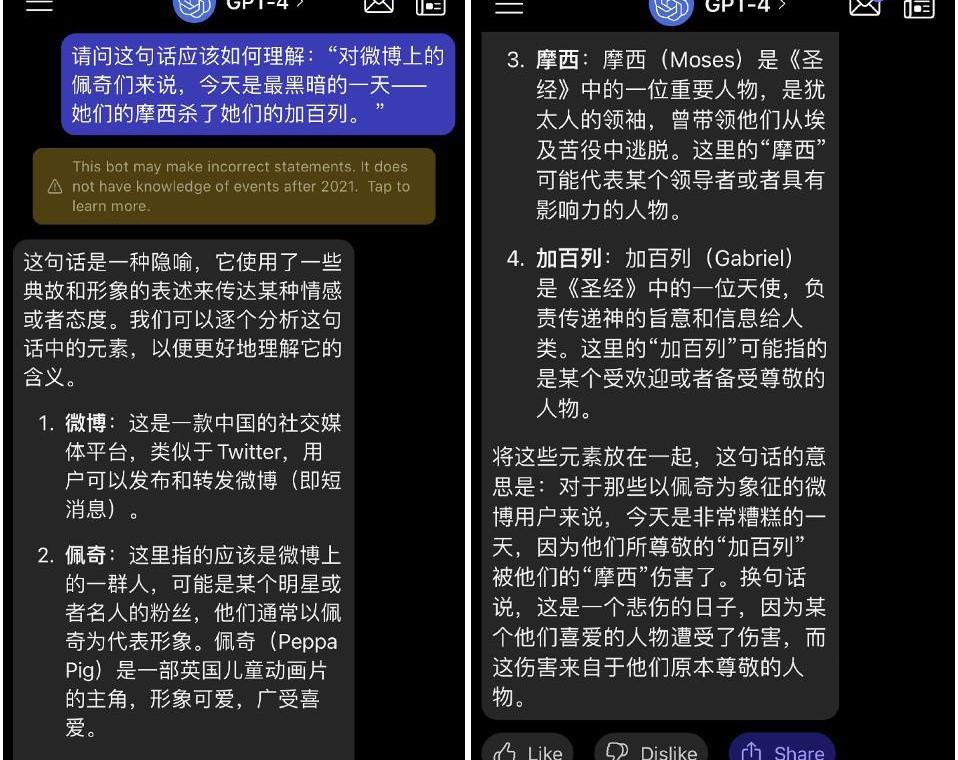

微博博主tombkeeper做过这样一个测试:在ChatGPT刚诞生时,他将发表于2018年的一篇充满隐喻的微博——“对微博上的佩奇来说,今天是黑暗的一天——她们的摩西杀死了她们的加百列”,交给ChatGPT理解,但ChatGPT回答失败了。

来源:微博tombkeeper

而等到2023年3月OpenAI推出了GPT-4,tombkeeper再次将这个问题扔给AI,回答基本接近满分。

来源:微博tombkeeper

Google在训练大模型PaLM时,也发现随着参数规模的增加,模型会不断“涌现”出新的能力。

当最终把PaLM的参数堆到5400亿时,模型就具备了区分因果关系、理解上下文概念、解释冷笑话等能力。比如像前文一样根据4个emoj表情符号来猜电影名字。

对于大模型“涌现”的背后逻辑,现在几乎没有科学家能彻底讲清楚。这让人想起了1950年阿兰?图灵在《计算机器与智能》这篇论文中论述过一个观点:“学习机器有一个重要的特征,即它的老师往往对机器内部运行情况一无所知。”

当然,有人对此欣喜若狂,有人则会觉得毛骨悚然。不过无论是哪一派,都不得不承认那句老话:大力真的能出奇迹。“大力”背后就是信仰——人类一定可以用硅基来模仿大脑结构,最终实现超越人类的智能。而“涌现”告诉我们:这一刻越来越近了。

信仰的充值

有信仰,就要对信仰充值。中世纪基督徒用的是赎罪券,新世纪AI信徒用的则是晶体管。

文心一言面世之后,李彦宏的一段采访曾冲上热搜——李厂长直言“中国基本不会再诞生一家OpenAI”,这似乎有点儿不太给王慧文面子。但这一观点确实有理有据:大模型军备竞赛,大概率会比曾经烧掉数十亿美金的网约车战争还要惨烈。

如果按照业界预估的成本,GPT-4训练成本大约在1亿美金左右,GPT-3的训练费用也要1200万美元。先不说昂贵的人才团队费用,王慧文的5000万美元光是投入到GPU购买或租赁上,都显得捉襟见肘。

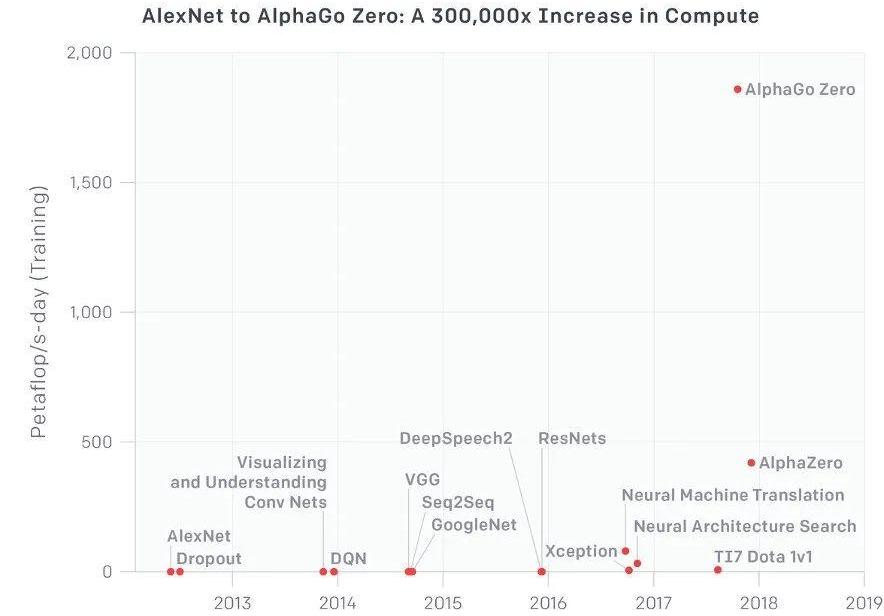

大模型发展的三要素:算法、算力、数据。其中算力是数字时代的“石油”,未来的缺口一定会越来越大。自2012年开启黄金时代后,AI对算力的需求开始呈现指数级增长。从2012年的AlexNet,到2017年的AlphaGoZero,算力消耗足足翻了30万倍。

训练大模型需要专门的GPU集群,传统数据中心的用场不大。微软为了“迎娶”OpenAI,曾特地配备了一台拥有数万块A100与H100GPU的超级计算机,光硬件入场费就花了近10亿美金。

即便如此,据相关机构测算,由于ChatGPT与GPT-4的访问量仍在增长,10亿美金的超级计算机马上又要不够用了。要么进一步扩大算力,要么只能尽力控制成本,继续采用限流等手段。

英伟达AI超算产品的第一个客户,就是OpenAI

对此,贴心的卖铲人英伟达推出了AI超算云服务:租赁8块旗舰版A100,每月只需37000美元,童叟无欺。若要达到训练GPT-4的算力月租金需4600万美元左右——每月净利润不足一个小目标的企业,的确可以洗洗睡了。

跟用神经网络来模仿大脑一样,AI算力的昂贵也跟人脑的属性保持一致。

一个人的大脑大约有860亿个神经元,每个神经元平均跟其它7000个神经元相连接,所以大约有6000万亿个连接。尽管大脑的重量只占人体的2%左右,但当无数神经元连接工作的时候,它们每天需要消耗人体总能量的20%~30%。

因此,即使是碳基生物的“智能”,也是一种暴力堆砌神经元后的“涌现”,对能量的消耗巨大。而相比经过上亿年进化的碳基神经元,晶体管构建的神经网络离“低功耗”相距甚远——比如柯洁功率是20w,而跟他下棋的AlphaGo功耗是他的5万倍。

因此,人类要想做出真正的AGI,还需要继续给信仰来充值。

对全人类来说,这种充值显然是无比划算的。仔细算一算,OpenAI烧掉的10亿美金,不仅给全球的科技公司找到了一片“新大陆”,还给愈发内卷的全球经济点亮了增量逻辑。在美元泛滥的当下,还有比这10亿美元性价比更高的项目吗?

当“新大陆”被发现后,全世界都会蜂拥而至。比尔?盖茨虽然现在是AI的狂热鼓吹者,但早在微软第一次投资OpenAI时,他是强烈的怀疑者,直到去年年底看到GPT-4的内部演示才对外表示:It’sashock,thisthingisamazing。

比尔?盖茨在未来可能拥有人工智能领域最雄伟大厦的冠名权,但OpenAI的创始人们、以及更多连接主义学派的人工智能先驱,值得人们在广场上树立雕像。大模型的炼丹之路,信则灵,不信则妄,跟风的投机主义者不配留下姓名。

最后,人类通往地狱或者天堂的道路,一定是由AI虔诚的信徒用一颗颗晶体管铺就的。

参考资料

ChatGPTandgenerativeAIarebooming,butthecostscanbeextraordinary,CNBC

MicrosoftspenthundredsofmillionsofdollarsonaChatGPTsupercomputer,TheVerge

EmergentAbilitiesofLargeLanguageModels,JasonWei等,TMLR

TheUnpredictableAbilitiesEmergingFromLargeAIModels

137emergentabilitiesoflargelanguagemodels,JasonWei

HarnessingthePowerofLLMsinPractice

Alphabet’sGoogleandDeepMindPauseGrudges,JoinForcestoChaseOpenAI,TheInformation

编辑:戴老板

视觉设计:疏睿

责任编辑:戴老板

早在2016年,consensys就试图将比特币和以太坊这两条区块链连接起来,开发了BTCRelay这个项目,实现让以太坊链能够知晓比特币的特定交易,从而实现了在无需托管BTC的前提下.

1900/1/1 0:00:00在上篇文章中我提到,Meta放弃了将NFT集成到他们的核心产品Facebook和Instagram的计划。如果市场没有因为银行业的危机而陷入恐慌,这件事本应引起相当大的关注.

1900/1/1 0:00:00文/TRMInsights,译/金色财经xiaozou伊朗经济在整个2022年遭受了新冠疫情、国家内乱以及限制其进入外国金融市场的国际制裁的持久影响.

1900/1/1 0:00:00头条▌以太坊基金会研究员披露质押以太坊或会泄露用户IP地址等信息4月14日消息,以太坊基金会研究员JustinDrake透露,ETH质押者的IP地址作为元数据集的一部分受到了监控.

1900/1/1 0:00:007:00-12:00关键词:Coinbase、推特减员、星巴克NFT、英国央行1.Helium将于北京时间4月19日凌晨起开始向Solana网络迁移;2.

1900/1/1 0:00:00原文作者:Darren,EverestVenturesGroup上海升级暂定于4月?13日进行,将首次允许验证者从信标链撤出以及提款。相关预期迭加,市场又一次将注意力聚焦于以太坊流动性.

1900/1/1 0:00:00